Здравствуйте уважаемые читатели и подписчики. Как проходит лето? Надеюсь, более чем насыщенно. В сегодняшнем посте мы опять поговорим о продвижении сайта, а если быть более точным, то уделим внимание поиску и устранению дублей страниц.

Прежде чем начать, хотелось бы рассказать новичкам, что вообще такое дубли и как они могут препятствовать продвижению. Дубли страниц возникают из-за того, что один тот же контент доступен по разным адресам. Например: sayt.ru/statja и www.sayt.ru/statja. Это приводит к тому, что контент на сайте становится неуникальным и позиции в поисковых системах падают. Чаще всего дубли возникают из-за особенности той или иной CMS (движка блога), а также из-за неопытности и невнимательности вебмастера.

Дубли можно разделить на 2 категории: полные и не полные. В перовом случае дублируется вся страница, во втором, только ее часть, например, после анонса в RSS.

Если на своем сайте Вы обнаружили дубли контента, то вот с какими проблемами Вы можете столкнуться при продвижении:

- Потеря внутреннего ссылочного веса. Это может произойти из-за того, что ссылки ведут на дублированные страницы, вместо того чтобы увеличивать вес продвигаемой. Простой пример: при внутренней перелинковке, Вы можете случайно ошибиться и сослаться на дублированную страницу, в таком случае вес страницы пропадает в пустую.

- Подмена основной страницы в индексе. Дублированная страница может быть расценена поисковиками как оригинальная и свободно попасть в основной индекс. Если такое произойдет, то все усилия по ее продвижению будут напрасны и соответственно позиции по нужным запросам просядут.

- Если дублей очень много, то есть риск попадания под фильтр Яндекса АГС.

Теперь, когда мы узнали определение и последствия дублей, можно приступать к их поиску и устранению. Устранение сводиться к тому, чтобы запретить дублям индексироваться

Устранение самых распространенных дублей

Сайт доступен с www и без www

Откройте главную страницу сайта. У меня это life-webmaster.ru (без www, но у Вас может быть наоборот). Теперь уберите или допишите к адресу www. Если дубля нет, то Вас будет автоматически перебрасывать на основное зеркало. Если сайт доступен и с www и без него – это дубль и от него нужно избавляться.

Делается это очень просто. Если вы хотите сделать сайт доступным без www, то в конец файла .htaccess пишем этот код:

Options +FollowSymLinks

RewriteEngine On

RewriteCond %{HTTP_HOST} ^www.domain.com$ [NC]

RewriteRule ^(.*)$ http://domain.com/$1 [R=301,L]

Если с www, этот:

RewriteEngine On

RewriteCond %{HTTP_HOST} !^www.(.*) [NC]

RewriteRule ^(.*)$ http://www.%1/$1 [R=301,L]

В индексе присутствуют страницы с параметрами page=1; .php и т.д.

Эта проблема наблюдается в основном у тех, кто использовал движок Wordpress для создания своего сайта. Дело в том, что URL, который использует данный движок для записей, выглядит следующим образом: sayt.ru/?p=1. Это не очень хорошо, но решается тегом rel=”canonical”, который есть в любом seo плагине. Если у Вас другая CMS, то зайдите в файл index.php и добавьте этот тег вручную. Если тег rel=”canonical” уже прописан на Вашем сайте, this is хорошо.

Дубли со слешами на конце

Суть в том, что страница доступна по ссылке со слешем (/) и без него. Проверяется следующим образом:

- Открываем статью сайта

- Например, у меня открылась sayt.ru/statja/ (т.е. со слешем)

- Теперь убираем слеш, получиться sayt.ru/statja

Если одни и те же страницы будут открываться со слешем и без него, то это дубль:

- sayt.ru/statja

- sayt.ru/statja/

Устранить эту проблему можно прописав в конец файла .htaccess следующее правило:

RewriteBase /

RewriteCond %{HTTP_HOST} (.*)

RewriteCond %{REQUEST_URI} /$ [NC]

RewriteRule ^(.*)(/)$ $1 [L,R=301]

Оно уберет слеш на конце ссылки и будет перенаправлять пользователя на правильную страницу. Например, человек ввел в адресную строку адрес sayt.ru/statja/ и его тут же перебросит на sayt.ru/statja

Этими действиями мы предотвратили появление в индексе дублированного контента, но что делать, если таковой уже имеется в выдаче? В таком случае нужно отыскать, и избавится от него вручную.

Поиск дублированного контента в индексе

Есть множество способов найти дублированный контент, давайте рассмотрим самые основные:

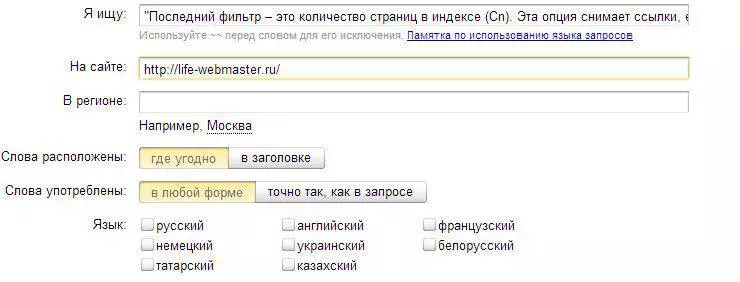

Расширенный поиск Яндекса. Заходим в этот поисковик и жмем “расширенный поиск”:

Берем кусок текста из старого поста, заключаем его в кавычки и вставляем в строку поиска. Далее вводим адрес блога и жмем “Найти”:

Если по таким запросам показывается несколько страниц, то это дубли. Заметьте, что нужно брать текст из середины или конца поста, потому как первые предложения могут встречаться на главной странице или в рубриках блога.

Если найдены дубли, то удалите их с помощью этого инструмента из Яндекс Вебмастера.

Конечно, если на Вашем сайте тысячи страниц то проверять его ручками можно вечно, поэтому для упрощения работы придумана программа XENU.

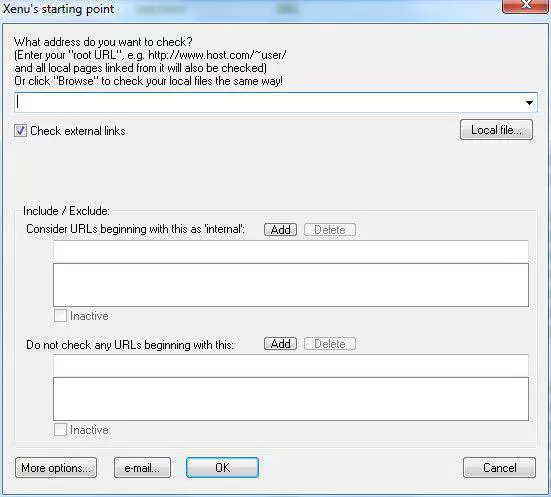

Проверка с помощью программы Xenu. Эта программа проанализирует все ссылки Вашей площадки и укажет на возможные ошибки. Программка на английском, но разобраться в ней несложно.

Итак, скачиваем ее отсюда (жмем кнопку Download) и устанавливаем на компьютер. После установки запустите программу, перейдите в раздел “file” и выберите подраздел “check URL”:

Здесь введите адрес нужного сайта и нажмите ok. Начнется процесс проверки ссылок. Прошу заметить, что полная проверка может длиться достаточно долго, поэтому не переживаем.

Все ошибки будут подсвечены красным цветом, поэтому распознать проблемные страницы будет несложно. После анализа, программа предложить сделать карту сайта, но этого делать не нужно.

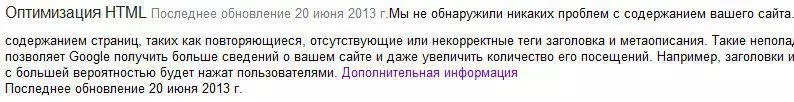

Еще одним удобным способом проверки дублированных страниц является инструмент в Google Webmaster. Если Ваш сайт добавлен туда, то перейдите в раздел “оптимизация”, а затем в “оптимизация html”. Здесь будут показаны одинаковые тайтлы и description, что говорит о дублированном контенте. Если все good, то ы увидите следующие:

После нахождения дублей анализируйте их появление, и устраняйте вышеперечисленными способами. Если найдены дубли с непонятными адресами, то закрывайте их от индексации через robots.txt. Также если на Вашем сайте есть архив записей, то его тоже лучше закрыть от индексации в robots.txt либо через All in One Seo Pack.